Machines Out of Control - آلات خارجة عن السيطرة

By: Mariam Ahmed, Omar Badr and Hatem Essam

English Version

Imagine yourself a scientist living in 1905s, and some dude with messy hair reached out to you. He told you that “E = mc^2” and mass is just another form of energy, and when you asked him for a proof, instead of giving you one, he told you that he just dreamt about it.

Now, you are thinking of two ways to deal with him, the first one is that “this man is crazy.”

The second way, you sit down and try to find an explanation for what he’s saying.

Of course, we know that this didn’t happen, but there’s a very specific definition of what happened, and that is “black box,” which is simply when you get a specific result and you are unable to explain it. Your process of getting it is a black box.

Since humans have been researching and experimenting for thousands of years, they have developed a way to prove and explain things, that’s why you may never find many black boxes in modern science, but on the other hand this isn’t true for machines, machines that can learn by themselves!

Black Boxes and Neural Networks

So you may be thinking what does the black box paradox have to do with machines, but I am not talking about ordinary machines; I am talking about deep neural networks machines.

To understand this well, I am going to take you on a ride in the world of neural networks and how it works.

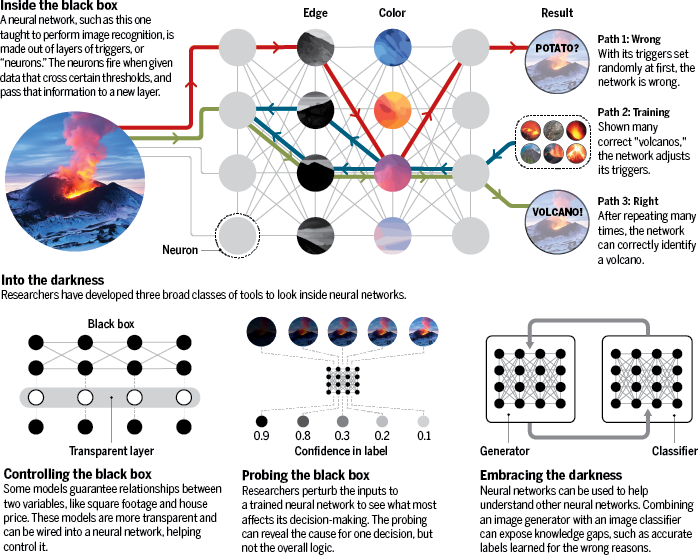

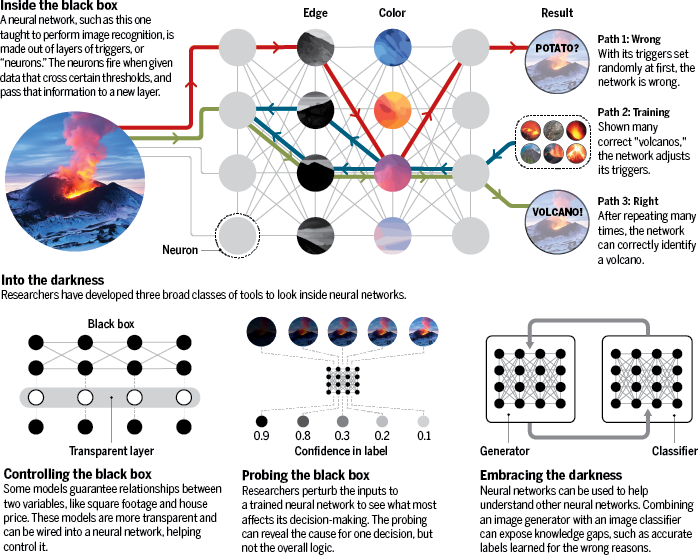

To think of how neural networks work, you can say it’s roughly similar to how your brain works. Neural machines consist of nodes (we can call them neurons,) think of these neurons as variables or a placeholder that holds a value from 0 to 1.

These neurons are organised as layers where they are connected to each other by links, each neuron is connected to other neurons that are in the layer before it, each neuron triggers or gives a high value between 0 and 1 if they capture a feature they desire. Whenever the layers increase, you find the neurons detect a much more complex feature until it reaches the output layer, where it decides if this input holds the value we want.

The real difference between these networks and our brains is that they are trained backwards! When they get a wrong answer, you give them the right values from the output and everytime neurons adjust the links between themselves slightly to get the right answer next time.

They do this automatically. Don’t worry this is done using Algebra not magic. All you have to do is repeat this a million times and in the end you get a network that can identify a cat from a thousand dogs.

This is an image that can help you understand how neural networks work.

This is an image that can help you understand how neural networks work.

What is the problem?

“It can get the right analysis for the wrong reasons ”

So what does the black box have to do with all this? The simplest answer for this is that the layers between the input and output are just hidden layers. You can’t look at them and understand what they are. They are just a bunch of neurons that are connected in a certain way. They are not code. And this, ladies and gentlemen, is the black box.

You may wonder: “if it is working, then what is the problem?”

The answer is that it is not a problem if you just want to identify cats from pictures, but if you want your neural network to solve life and death problems then that’s a huge problem.

If your network is going to drive your car, or your doctors will use it to diagnose someone with cancer, or be responsible to tell you if North Korea will start a world war. Then, you need to understand how it gets these results because you need to explain to the decision maker why the network gives you that analysis.

Elucidating the Black Box

Just like neurosurgeons using tools to look into the brain of a human, researchers have developed tools to explore the brain of the AI, and then classified it into three classes:

- Controlling the black box

- Probing the black box

- Embracing the darkness

Here’s an example of a couple of tools and methods used:

One approach suggested by Marco Ribeiro, is to use tools known as “counterfactual probes.” These probes keep altering the inputs in a way to reveal which inputs influence the final output or decision making. The problem with this method is that AI needs to be tested thousands of times over and over. That is when Sundararajan and his team thought of a more effective way, introduce a blank reference (black image or an array of zeros) and keep adding inputs to transition it or the example being tested, instead of changing the inputs randomly.

Ironically enough, another way of glassing out the black box of the AI, is by using AI.

Mark Riedl made a neural network able to explain itself while playing a game, by using an aiding trained neural network that translates the computer language into understandable human language. While making that translator neural network Riedl had people play the game and explain the reason for each step, and made the neural network code these steps of the players.

Conclusion

We’ve seen numerous sci-fi movies about “Robots taking over,” and we think of it just like we do with Zombies Apocalypse movie tropes. It is just fiction, right?

Now look back at how we’ve reached a point, where we are unable to explain how the work of our own hands works, taking in consideration the incident of Two AIs communicating with each other with a language they invented that humans couldn’t understand. What do you think of it now?

Maybe these movie tropes that we’ve always watched for entertainment are actually predictions of the future we’re pushing ourselves towards.

“This is a good start for my plan to dominate the human race.” -Sophia the robot

Arabic Version

لنتخيل أنك عالِم في عام 1905، و يأتيك شخصًا ذو شعر فوضوي يخبرك بأن الطاقة تساوي الكتلة في تربيع سرعة الزمن، و أن الكتلة ما هي إلا مجرد شكل آخر للطاقة. عند سؤاله عن تفسير علمي لكلامه، يقول لك “لقد حلمت بهذه المعادلة” بدلًا من أن يعطيك تفسير مقنع لهذه المعادلة. وهنا لديك خيار من اثنين، إما أن تعتبر هذا الشخص مجنوناً، أو إما أن تحاول أن تفسر ما قاله بنفسك.

بالطبع نحن على علم جميعا أن هذا لم يحدث، لكن هناك عبارة مشهورة تعرف ما حدث. ألا و هي معضلة الصندوق الأسود، الصندوق الأسود هي ببساطة عبارة تطلق عندما لا يستطيع الإنسان أن يفسر كيف وصل لنتيجة ما أو ما تفاصيل هذه العملية، لذلك هي بالنسبة لك كالصندوق الأسود.

ولكن بسبب جهود البشر المستمرة على تفسير كل ما يحدث حولنا عن طريق البحوثات و التجارب، ستجد أن الظاهرة نادرة الحدوث عند البشر، و لكن على الجانب الآخر لا يمكنك قول ذلك على آلات أو بالأحرى على آلات تعلم نفسها.

معضلة الصندوق الأسود و شبكات التعلم العميق العصبية

هنا قد يدور في بالك سؤال مهم “ما هي العلاقة بين معضلة الصندوق الأسود و الآلات؟ “ لكنني لا أتحدث هنا عن الآلات العادية ؛ أنما أتحدث عن آلات الشبكات العصبية العميقة أو ال deep neural network ، لذا لكي نفهم هذه العلاقة جيدًا، سأصحبكم في رحلة في عالم الشبكات العصبية العميقة وكيف تعمل.

للتفكير في كيفية عمل الشبكات العصبية أو neural networks، يمكنك القول إنها مشابهة تقريبًا لكيفية عمل دماغك ، تتكون الشبكة العصبية من ما نسميها الخلايا العصبية أو neurons، فكر في هذه الخلايا العصبية كمتغير يحمل قيمة من 0 إلى 1 ، يتم تنظيم هذه الخلايا العصبية على شكل صفوف أو طبقات حيث ترتبط بعضها ببعض عن طريق الروابط، كل خلية عصبية متصلة بخلايا عصبية أخرى موجودة في الطبقة التي تسبقها، كل خلية عصبية تمثل ميزة معينة أو نمط معين في مُدخلاتنا، وكلما زادت الطبقات، كلما وُجدت الخلايا العصبية تكتشف ميزة معقدة للغاية حتى تصل إلى طبقة الخيرة، هذه الطبقة تقرر ما إذا كانت المدخل الذي وضعناه يحمل القيمة التي نريدها.

علي سبيل المثال إذا اردنا أن نطور شبكة الخلايا العصبية لتتعرف على القطط ، فستكون أول طبقة هي بيكسلز التي في الصورة و ستكون الطبقة الثانية بها خلايا عصبية مسؤولة عن تحديد الحواف في الأشكال، الطبقة التي تليها بها الخلايا العصبية مسؤولة عن تحديد الأشكال و هكذا حتى تصل لطبقة معينة سيكون بها أثنان من الخلايا العصب، واحدة تخبرك أنها قطة بالفعل و أخرى تخبرك بأنها العكس و على حسب الصورة ستنشط واحدة منهم في النهاية.

الفرق الحقيقي بين هذه الشبكات و أدمغتنا أنها مدربة رجعية! أي أنها عندما تحصل على إجابة خاطئة تخبرها بالإجابة الصحيحة. فتقوم بالتلاعب بالروابط بين الخلايا العصبية قليلًا للحصول على الإجابة الصحيحة في المرة القادمة. كل خلية عصبية تقوم بذلك كل مرة تلقائيًا. و لا تقلق، تتم هذه العملية باستخدام الجبر و الرياضات وليس السحر، وكل ما عليك فعله هو تكرار هذه مليون مرة و في النهاية تحصل على شبكة يمكنها التعرف على قطة من بين ألف كلب.

هذه الصورة توضح كيف تعمل الشبكات العصبية بشكل أوضح

إذا ما المشكلة؟

إذن ما يزال السؤال قائماً، ما علاقة الصندوق الأسود بكل هذا، وأبسط إجابة لهذا هو أن الطبقات بين المدخلات (input layer) والمخرجات (output layer) هي طبقات مخفية، لا يمكن النظر إليها وفهم ماهيتها، فهي مجرد مجموعة من الخلايا العصبية المتصلة بطريقة معينة، ليست مجموعة من الأكواد التي تستطيع قراءتها. هي مجرد مجموعة من المتغيرات التي تحمل قيم و هذه المتغيرات متصلة ببعضها، ولذلك لقبها صانعيها بالصندوق الأسود.

قد تتساءل: “إنها تعمل، فما هي المشكلة؟”، الإجابة هي أن الأمر ليس مشكلة إذا كنت تريد فقط التعرف على القطط من الصور ، ولكن إذا كنت تريد شبكتك العصبية أن تأخذ قراراً مهمًا في مسألة حياة أو موت، فهذه مشكلة كبيرة. إذا كانت شبكتك ستقود سيارتك، أو سيستخدمها الأطباء في تشخيص شخص مصاب بالسرطان، أو أنها مسؤولة عن إخبارك ما إذا كانت كوريا الشمالية ستبدأ حربًا عالمية، فأنت بحاجة إلى فهم كيفية حصولها على هذه النتائج لأنك بحاجة إلى أن تشرح لصانعي القرار سبب إعطاء الشبكة لهذا التحليل.

من صندوق أسود إلى صندوق زجاجي

جراحين الأعصاب الذين يستعملون أجهزة و أدوات لفحص ومعالجة مخ الإنسان، طور الباحثون أدوات فحص مخ الذكاء الاصطناعي، و صنفوا الأدوات ثلاثة تصنيفات:

- أدوات التحكم في الصندوق الأسود

- استكشاف الصندوق الأسود

- تقبل السواد (Embracing the darkness technique )

هناك بعض الطرق التي يحاول بها العلماء حل مشكلة الصندوق الأسود.

اتبع ماركو روبيرو نهجًا يستعمل فيه ادوات سماها المجسات الواقعية (counter-factual probes)، تعمل تلك المجسات على تغيير المدخلات بطريقة ذكية لإظهار المدخلات التي تؤثر بشكل كبير على الشبكة العصبونية الاصطناعية (neural network) في اتخاذ القرارات أو إظهار النتائج. مشكلة هذه الطريقة تكمن في تكرار العملية آلاف المرات قبل الوصول إلى نتيجة. لاحظ هذة المشكلة و حاول حلها أحد علماء جوجل و هو الباحث سندراراجان وفريقه، قام سنجرارجان بإيجاد طريقة فعالة أكثر و هي أن يبدأ إسناد فارغ (كصورة سوداء أو مقصوصة أصفار) و خطوة بخطوة يجول الإسناد الفارغ إلي الصورة الاصلية، هذه الطريقة تسهل تتبع خطوات الشبكة العصبية لحظة بلحظة بدلاً من تغيير المدخلات بشكل عشوائي.

فكر مارك ريدل بحل ساخر قليلا لمشكلة الصندوق الأسود، ألا و هي الاستعانة بالذكاء الاصطناعي لفهم الذكاء الاصطناعي! باستعمال شبكة مترجمة استطاع مارك ريدل صنع شبكة عصبية قادرة على تفسير افعالها و اختياراتها أثناء لعب لعبة. كي يصل ريدل إلى تلك النتائج، أتى ببعض الأشخاص وجعلهم يلعبون اللعبة الالكترونية مع تفسير سبب كل خطوة أخطوها، و مرن شبكة عصبية على فهم وترجمة تلك التفسيرات إلى لغة الحاسوب، و من ثم دمجه مع الشبكة العصبية الأساسية اللاعبة.

الخاتمة

لقد رأينا العديد من أفلام الخيال العلمي المبنية على أن الإنسان الآلي يخرج عن السيطرة و يحارب البشر، لكننا نراها بنفس الطريقة التي نري بها أفلام نهاية العالم بسبب الأحياء الأموات (zombies)، مجرد خيال، أليس كذلك؟

لكن أنظر كيف وصلنا إلى مرحلة نعجز فيها عن تفسير ما صنعناه بايدينا، مع العلم أيضًا أن هناك مرة كان هناك جهازين قادرين على إختراع لغة والتواصل بها و لم يستطع البشر فهمها أو فكها. هل ستبقي نظرتك لتلك الأفلام كما هي؟

من المحتمل أن تلك الأفلام ليست من محض الخيال فقط و أنها توقعات لمستقبل نتجه نحوه. من يعلم؟

“إنها بداية جيدة لخطتي للسيطرة على الجنس البشري” -الإنسانة الآلية صوفيا

References

Voosen, P. (2017). How AI detectives are cracking open the black box of deep learning. Science. Published. https://doi.org/10.1126/science.aan7059

Explaining the AI black box problem. (2020, April 27). [Video]. YouTube. https://www.youtube.com/watch?v=8Wpt9EZ4gWQ

AI detectives are cracking open the black box of deep learning. (2017, July 6). [Video]. YouTube. https://www.youtube.com/watch?v=gB_-LabED68

But what is a neural network? | Chapter 1, Deep learning. (2017, October 5). [Video]. YouTube. https://www.youtube.com/watch?v=aircAruvnKk

Gradient descent, how neural networks learn | Chapter 2, Deep learning. (2017, October 16). [Video]. YouTube. https://www.youtube.com/watch?v=IHZwWFHWa-w